AI 사고력 벤치마크 'ScholarBench' 개발

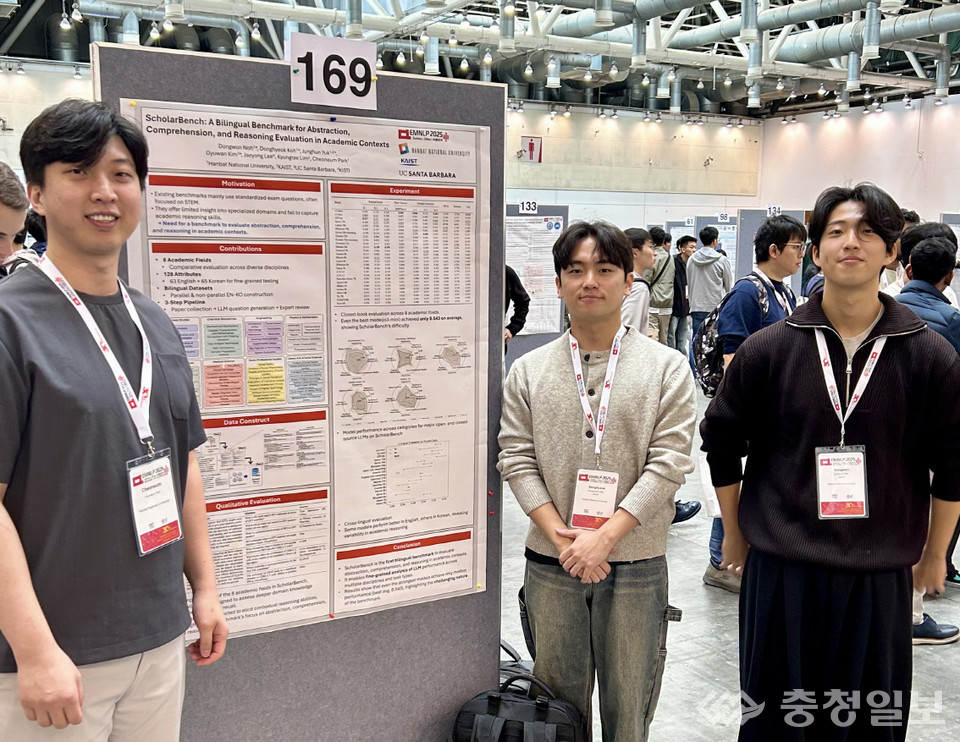

국제학회 EMNLP 2025 포스터 발표

이중언어 기반 학문 추론 평가모델 공개

거대언어모델의 한계를 실증적으로 드러낼 새로운 잣대가 대전에서 나왔다.

국립한밭대학교 연구팀이 인간의 학문적 사고를 모사하는 능력을 평가하기 위한 국제 벤치마크 'ScholarBench'를 구축하고, 자연어처리 분야 세계적 학회 EMNLP 2025에서 공식 발표했다.

이번 연구는 컴퓨터공학과 노동원 석사과정, 고동혁 학부생, KAIST 문화기술대학원 육정훈 석사과정, UCSB 김규완 박사과정이 공동 제1저자로 참여했고, 박천음 교수가 전체 연구를 이끌었다.

연구팀은 "거대언어모델이 제공하는 답변의 유창함과 실제 학문적 이해 능력은 전혀 다른 차원"이라며, 기존 벤치마크가 놓치고 있던 영역을 정면으로 겨냥했다.

첫째 ScholarBench는 추상화·이해·추론이라는 인지적 단계에 따라 문항을 구성해, 모델이 어느 단계에서 사고가 멈추는지 확인할 수 있도록 설계됐다.

둘째 자연과학·응용과학·사회과학·인문학 등 8개 학문 분야의 실제 연구 문장을 기반으로 문제를 만들었다. 키워드의 표면적 일치 여부가 아니라, 논증의 흐름과 개념 간 연결, 개념 전환까지 파악해야 풀 수 있는 구성이 특징이다.

셋째 한국어와 영어를 동일한 구조로 구성한 이중언어 벤치마크로 제작해 언어 간 사고력 균형을 측정할 수 있게 했다.

연구팀은 GPT-4o, Claude-3 등 최신 모델을 ScholarBench로 평가한 결과, 학문적 추론 단계에서는 평균 0.54 수준에 머무른다고 밝혔다. 표면을 파악하는 능력은 뛰어나지만, 논리적 결합과 개념적 변환에서 여전히 취약함이 드러난 셈이다.

박천음 교수는 "ScholarBench는 시험지 이상의 의미를 지니며, AI가 학술 정보를 어떤 방식으로 해석하고 사고하는지 보여주는 창"이라며 "한국어 기반 학문 AI 연구의 토대가 될 것"이라고 말했다.

이어 "비영어권 언어의 학문적 표현과 사고 구조를 평가할 수 있는 첫 시도라는 점에서 의미가 크며, 한국 연구자들이 국제 AI 평가 생태계에서 주도권을 확보하는 데 중요한 발판이 될 것"이라고 강조했다.

이번 연구 결과는 'ScholarBench: A Bilingual Benchmark for Abstraction, Comprehension, and Reasoning Evaluation in Academic Contexts'라는 제목으로 ACL Anthology에 공개됐으며, 중국 쑤저우에서 열린 EMNLP 2025 포스터 세션에서 연구진이 설계 원리와 실증 평가 내용을 직접 설명했다. /대전=이한영기자